DDPG

Basic Terminology

评估策略的方法

在使用折扣因子的基础上,记

为策略

关于

首先,对于某一个状态

那么对于

策略梯度定理

策略梯度定理阐释了如何计算策略的梯度,即:

注意这里求梯度的时候是没有考虑

Actor-Critic 模式

在上面的评估函数中,可以发现,想要统计出

- Actor:负责根据策略梯度定理调整参数

的值来更新策略 - Critic:学习一个Q的函数来拟合当前的价值函数,即拟合

此时更新的公式变成了:

Off-policy Actor-critic模式

如果此时的行动策略

Actor-Critic模式的参数更新方式

首先定义

换句话说,这里的

那么下面就可以给出在线和离线 两种方式下的参数更新方法

On-Policy Deterministic Actor-Critic

在该模式下,参数

对于价值函数的拟合参数

对于当前策略的参数

Off-Policy Deterministic Actor-Critic

在离线的情况下,更新的公式是比较类似的,只是第一个TD-Error的更新变成了:

为什么这里不用加重要性采样了?

原文中有一段话:

However, because the deterministic

policy gradient removes the integral over actions, we can

avoid importance sampling in the actor; and by using Q-

learning, we can avoid importance sampling in the critic.

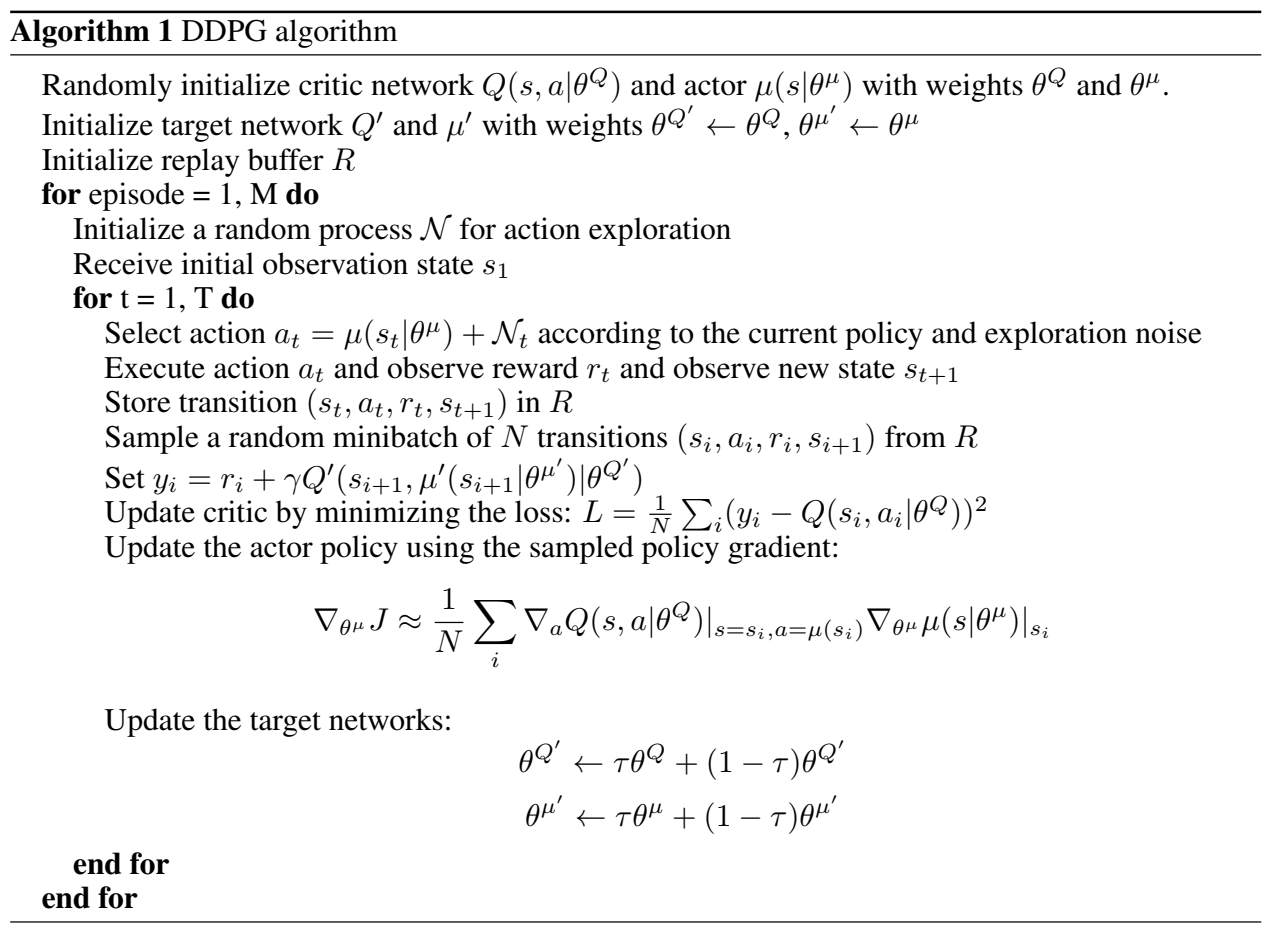

Algorithm

算法的结构如下图: